python lru_cache缓存机制

Python中的LRU缓存机制是一种常用的缓存策略,其中@lru_cache装饰器在functools模块中实现了这一功能。LRU代表最近最少使用(Least Recently Used),它的原理是将最近最少使用的数据或计算结果从缓存中淘汰出去,以便为新的数据腾出空间。

1. @lru_cache装饰器的实现

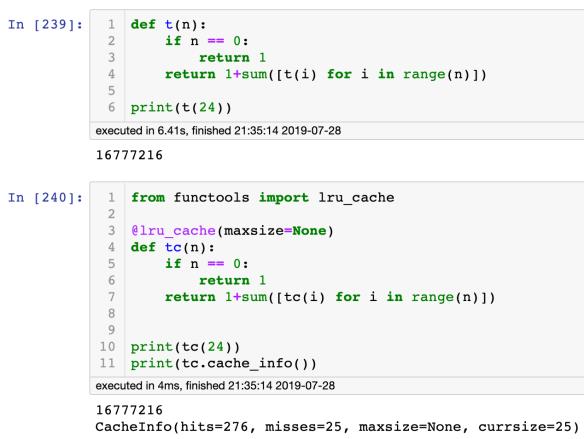

@lru_cache装饰器可以直接应用于函数上,它会自动将函数的结果缓存起来,以便后续的调用直接返回缓存的结果。具体实现如下:

from functools import lru_cache

@lru_cache(maxsize=None)

def my_function(arg1, arg2):

# 函数的计算逻辑

return result

在上述示例中,@lru_cache(maxsize=None)表示缓存大小不限制。如果需要限制缓存的大小,可以设置maxsize的值为一个正整数,例如@lru_cache(maxsize=1000)表示最多缓存1000个结果。

2. LRU缓存的工作原理

LRU缓存工作的核心思想是基于数据的访问模式,最近访问的数据会被认为是接下来可能会再次访问的数据,因此被保留在缓存中。当缓存空间不足时,LRU缓存会淘汰最近最少使用的数据。

LRU缓存通过使用一个哈希表和一个双向链表来实现。哈希表用于快速查找数据,双向链表用于记录数据的访问顺序。每当数据被访问时,它会被移到链表的头部,这样链表的尾部就是最近最少使用的数据。当缓存满时,淘汰链表尾部的数据即可。

3. LRU缓存的应用场景

LRU缓存适用于那些具有局部性的数据访问模式的场景,例如计算密集型任务中的重复计算、网络请求中的重复数据获取等。通过使用LRU缓存,可以大大提高程序的性能和效率。

4. LRU缓存的优势和注意事项

LRU缓存具有以下优势:

- 提高程序性能:通过缓存计算结果,避免重复计算,减少了程序的执行时间。

- 减少资源消耗:LRU缓存可以减少对底层资源(如数据库、网络等)的频繁访问,从而减少资源的消耗。

需要注意的是,LRU缓存也有一些限制和注意事项:

- 缓存大小限制:缓存大小的设置需要根据具体场景来决定,过大的缓存可能导致内存占用过高,过小的缓存可能无法满足需求。

- 数据一致性:对于需要保持数据一致性的场景,需要谨慎使用LRU缓存,因为缓存的数据可能不是最新的。

- 缓存命中率:LRU缓存的性能受到缓存命中率的影响,如果缓存命中率低,性能提升效果会较差。

总结

Python中的@lru_cache装饰器提供了一种简单而强大的LRU缓存策略。通过将函数的结果缓存起来,可以提高程序的性能和效率。LRU缓存的工作原理是基于数据访问模式,最近最少使用的数据会被淘汰出缓存。在使用LRU缓存时,需要注意缓存大小的设置、数据一致性和缓存命中率等因素。