光传播编程:开创高效神经网络新时代

当前,人工智能模型利用数十亿可训练参数来完成复杂任务。然而,这庞大的参数数量带来了巨大的代价。训练和部署这些庞大模型需要巨大的内存空间和计算能力,只能由规模庞大的数据中心提供,其能耗相当于中等规模城市的电力需求。

Optical Communication in CCNA - GeeksforGeeks

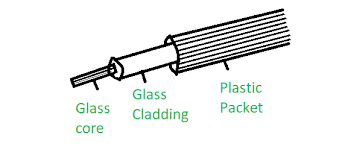

为了可持续地保持人工智能的发展速度,研究界正在努力重新思考相关的计算硬件和机器学习算法。在这方面,神经网络结构的光学实现是一个有前途的途径,因为它在单元之间实现连接时具有低功耗的优势。

最新的研究成果报告在《Advanced Photonics》杂志中发布,结合了多模光纤内的光传播与少量数字可编程参数,在图像分类任务上实现了与拥有100倍以上可编程参数的全数字系统相同的性能。这种计算框架简化了内存需求,减少了对高能耗数字过程的需求,同时在各种机器学习任务中实现了相同水平的准确性。

研究方法

该研究的核心工作由瑞士洛桑联邦理工学院(EPFL)的Demetri Psaltis教授和Christophe Moser教授领导,通过对多模光纤中超短脉冲的精确控制,利用波前整形技术实现非线性光学计算。这一技术使得微瓦级平均光功率下实现了光学神经网络潜在能力的关键一步。

研究的主要发现之一是,在一小组参数的帮助下,我们可以从光学提供的权重库中选择一组特定的模型权重,并将其用于目标计算任务。这样一来,我们就能够利用自然现象作为计算硬件,而无需制造和操作专门用于此目的的设备。

结果和影响

这一研究成果标志着在解决对更大型机器学习模型需求不断增长的挑战方面迈出了重要一步。通过利用光传播通过多模光纤的计算能力,研究人员为人工智能提供了低能耗、高效的硬件解决方案的道路。

正如非线性光学实验中展示的那样,这种计算框架还可以用于高效编程不同高维、非线性现象,从而执行机器学习任务,为当前人工智能模型的资源密集型特性提供了革命性的解决方案。

总结

通过光传播编程,瑞士洛桑联邦理工学院的研究团队在神经网络领域取得了突破性进展。他们通过波前整形技术的精准应用,成功实现了光学神经网络的非线性光学计算,将可编程参数数量大幅减少,从而减少了内存需求和能耗。这一研究为未来的人工智能硬件发展指明了一条可持续、高效的道路,为解决当前能源消耗和计算资源需求巨大的问题提供了新的思路。

| 参数数量 | 计算硬件 | 内存需求 | 能耗 |

|---|---|---|---|

| 数字神经网络 | 数十亿 | 巨大 | 大量电力 |

| 光学神经网络 | 少量可编程参数 | 减少 | 微小光功率 |

通过比较数字神经网络和光学神经网络的关键指标,我们可以清晰地看到光学神经网络在参数数量、内存需求和能耗方面的显著优势,为未来人工智能的可持续发展提供了希望。